[羅戈導(dǎo)讀]行人軌跡預(yù)測(cè)問題是無人駕駛技術(shù)的重要一環(huán),已成為近年來的一項(xiàng)研究熱點(diǎn)。在機(jī)器人領(lǐng)域國(guó)際頂級(jí)會(huì)議ICRA 2020上,美團(tuán)無人配送團(tuán)隊(duì)從一百多支隊(duì)伍中脫穎而出,在行人軌跡預(yù)測(cè)競(jìng)賽中奪得第一名。本文系對(duì)該預(yù)測(cè)方法的一些經(jīng)驗(yàn)總結(jié),希望能對(duì)大家有所幫助或啟發(fā)。

[羅戈導(dǎo)讀]行人軌跡預(yù)測(cè)問題是無人駕駛技術(shù)的重要一環(huán),已成為近年來的一項(xiàng)研究熱點(diǎn)。在機(jī)器人領(lǐng)域國(guó)際頂級(jí)會(huì)議ICRA 2020上,美團(tuán)無人配送團(tuán)隊(duì)從一百多支隊(duì)伍中脫穎而出,在行人軌跡預(yù)測(cè)競(jìng)賽中奪得第一名。本文系對(duì)該預(yù)測(cè)方法的一些經(jīng)驗(yàn)總結(jié),希望能對(duì)大家有所幫助或啟發(fā)。

6月2日,國(guó)際頂會(huì)ICRA 2020舉辦了“第二屆長(zhǎng)時(shí)人類運(yùn)動(dòng)預(yù)測(cè)研討會(huì)”,該研討會(huì)由博世有限公司、厄勒布魯大學(xué)、斯圖加特大學(xué)、瑞士洛桑聯(lián)邦理工聯(lián)合組織。同時(shí)在該研討會(huì)上,還舉辦了一項(xiàng)行人軌跡預(yù)測(cè)競(jìng)賽,吸引了來自世界各地的104支隊(duì)伍參賽。美團(tuán)無人配送團(tuán)隊(duì)通過采用“世界模型”的交互預(yù)測(cè)方法,奪得了該比賽的第一名。

圖1 ICRA 2020 TrajNet++軌跡預(yù)測(cè)競(jìng)賽

本次競(jìng)賽提供了街道、出入口、校園等十個(gè)復(fù)雜場(chǎng)景下的行人軌跡數(shù)據(jù)集,要求參賽選手根據(jù)這些數(shù)據(jù)集,利用行人在過去3.6秒的軌跡來預(yù)測(cè)其在未來4.8秒的運(yùn)行軌跡。競(jìng)賽使用FDE(預(yù)測(cè)軌跡和真實(shí)軌跡的終點(diǎn)距離)來對(duì)各種算法進(jìn)行排名。

本次的賽題數(shù)據(jù)集,主要來源于各類動(dòng)態(tài)場(chǎng)景下的真實(shí)標(biāo)注數(shù)據(jù)和模擬合成數(shù)據(jù),采集頻率為2.5赫茲,即兩個(gè)時(shí)刻之間的時(shí)間差為0.4秒。數(shù)據(jù)集中的行人軌跡都以固定坐標(biāo)系下的時(shí)序坐標(biāo)序列表示,并且根據(jù)行人的周圍環(huán)境,這些軌跡被分類成不同的類別,例如靜態(tài)障礙物、線性運(yùn)動(dòng)、追隨運(yùn)動(dòng)、避障行為、團(tuán)體運(yùn)動(dòng)等。在該比賽中,參賽隊(duì)伍需要根據(jù)每個(gè)障礙物歷史9個(gè)時(shí)刻的軌跡數(shù)據(jù)(對(duì)應(yīng)3.6秒的時(shí)間)來預(yù)測(cè)未來12個(gè)時(shí)刻的軌跡(對(duì)應(yīng)4.8秒的時(shí)間)。

該競(jìng)賽采用多種評(píng)價(jià)指標(biāo),這些評(píng)價(jià)指標(biāo)分別對(duì)單模態(tài)預(yù)測(cè)模型和多模態(tài)預(yù)測(cè)模型進(jìn)行評(píng)價(jià)。單模態(tài)模型是指給定確定的歷史軌跡,預(yù)測(cè)算法只輸出一條確定的軌跡;而多模態(tài)模型則會(huì)輸出多條可行的軌跡(或者分布)。本次競(jìng)賽的排名以單模態(tài)指標(biāo)中的FDE指標(biāo)為基準(zhǔn)。

其實(shí),美團(tuán)在很多實(shí)際業(yè)務(wù)中經(jīng)常要處理行人軌跡預(yù)測(cè)問題,而行人軌跡預(yù)測(cè)的難點(diǎn)在于如何在動(dòng)態(tài)復(fù)雜環(huán)境中,對(duì)行人之間的社交行為進(jìn)行建模。因?yàn)樵趶?fù)雜場(chǎng)景中,行人之間的交互非常頻繁并且交互的結(jié)果將會(huì)直接影響他們后續(xù)的運(yùn)動(dòng)(例如減速讓行、繞行避障、加速避障等)。

基于各類帶交互數(shù)據(jù)集,一系列的算法被相繼提出,然后對(duì)障礙物進(jìn)行交互預(yù)測(cè),這些主流模型的工作重心都是針對(duì)復(fù)雜場(chǎng)景下行人之間的交互進(jìn)行建模。常用的方法包括基于LSTM的交互算法(SR LSTM[1]、Social GAN[2]、SoPhie[3]、Peeking into[4]、StarNet[5]等),基于Graph/Attention的交互算法(GRIP[6]、Social STGCNN[7]、STGAT[8]、VectorNet[9]等),以及基于語(yǔ)義地圖/原始數(shù)據(jù)的預(yù)測(cè)算法等。

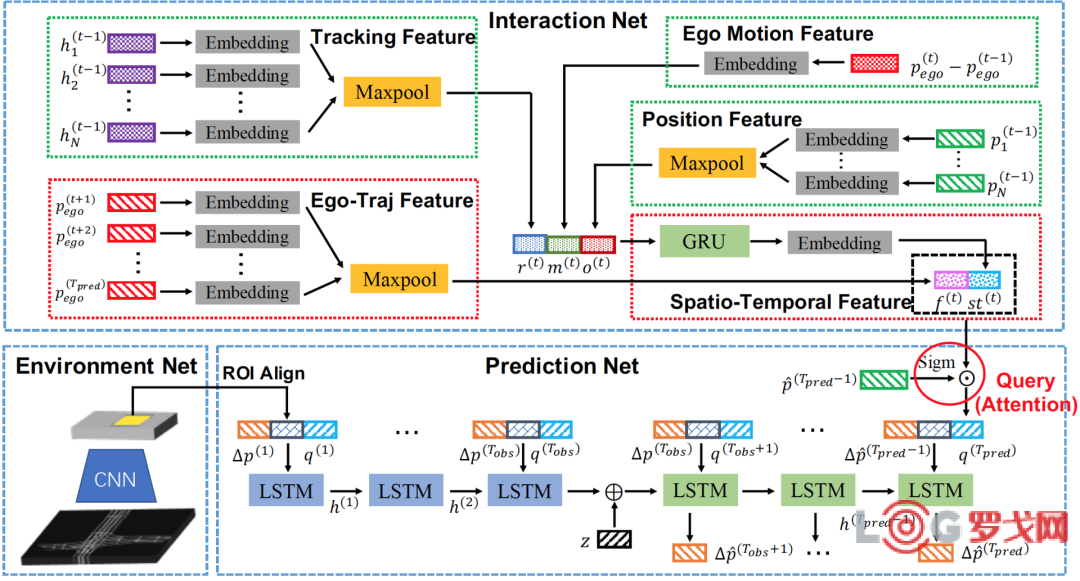

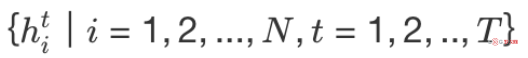

我們本次的參賽方法就是由自研算法[10](如圖2所示)改進(jìn)而來,該方法的設(shè)計(jì)思路是根據(jù)場(chǎng)景中所有障礙物的歷史軌跡、跟蹤信息以及場(chǎng)景信息,建立并維護(hù)一個(gè)全局的世界模型來挖掘障礙物之間、障礙物與環(huán)境之間的交互特性。然后,再通過查詢世界模型來獲得每個(gè)位置鄰域內(nèi)的交互特征,進(jìn)而來指導(dǎo)對(duì)障礙物的預(yù)測(cè)。

圖2 基于世界模型的預(yù)測(cè)算法

在實(shí)際操作過程中,由于數(shù)據(jù)集中缺乏場(chǎng)景信息,我們對(duì)模型做了適當(dāng)?shù)恼{(diào)整。在世界模型中(對(duì)應(yīng)上圖的Interaction Net),我們僅使用了現(xiàn)有數(shù)據(jù)集,以及模型能夠提供的位置信息和跟蹤信息LSTM隱狀態(tài)信息。最終得到的模型結(jié)構(gòu)設(shè)計(jì)如下圖3所示:

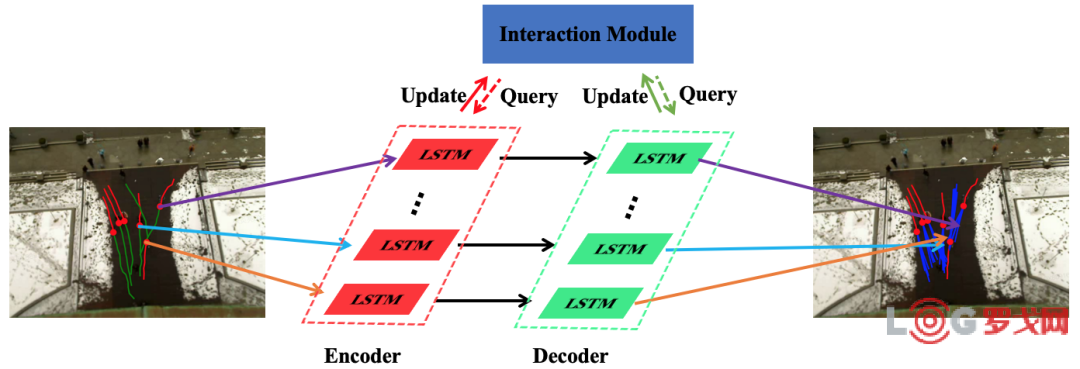

整個(gè)模型基于Seq2Seq結(jié)構(gòu),主要包含歷史軌跡編碼模塊(Encoder)、世界模型(Interaction Module)和解碼預(yù)測(cè)模塊(Decoder)三個(gè)部分。其中,編碼器的功能在于對(duì)行人歷史軌跡進(jìn)行編碼,主要提取行人在動(dòng)態(tài)環(huán)境中的運(yùn)動(dòng)模式;解碼器則是利用編碼器得到的行人運(yùn)動(dòng)模式特征,來預(yù)測(cè)他們未來的運(yùn)動(dòng)軌跡分布。

需要強(qiáng)調(diào)一下,在整個(gè)編碼與解碼的過程中,都需要對(duì)世界模型進(jìn)行實(shí)時(shí)更新(Update)與查詢(Query)兩種操作。更新操作主要根據(jù)時(shí)序的推進(jìn),將行人的運(yùn)動(dòng)信息實(shí)時(shí)編入世界模型中;查詢操作則是根據(jù)全局的世界地圖以及行人的自身位置,來獲取行人當(dāng)前鄰域內(nèi)的環(huán)境特征。

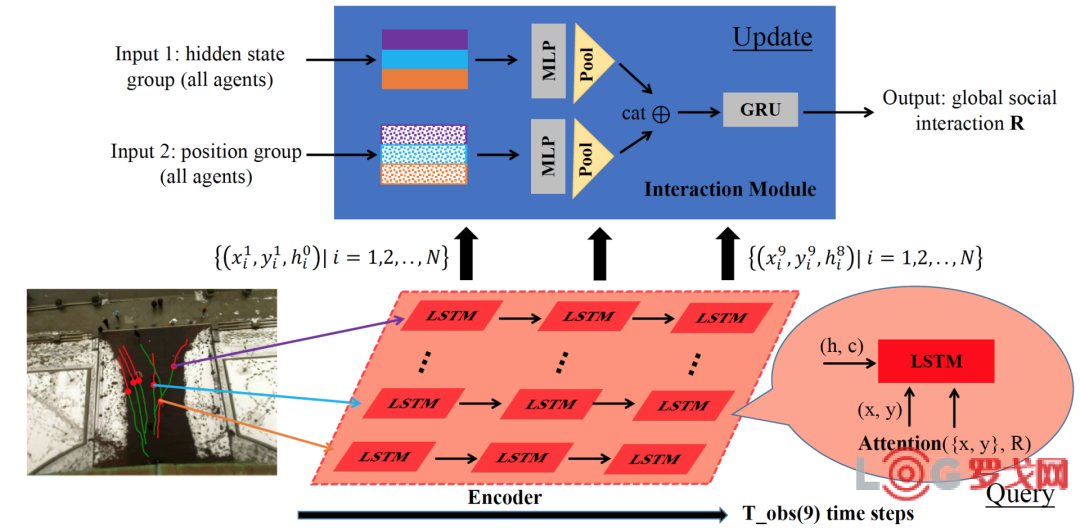

圖4 編碼階段

在圖4中,展示了我們模型在歷史軌跡編碼階段的計(jì)算流程。編碼階段共有9個(gè)時(shí)刻,對(duì)應(yīng)9個(gè)歷史觀測(cè)時(shí)間點(diǎn),每個(gè)時(shí)刻都執(zhí)行相同的操作。以t時(shí)刻為例。

首先,將t時(shí)刻的所有行人坐標(biāo)數(shù)據(jù),包含:

位置集合

速度集合

所有行人跟蹤信息(上時(shí)刻編碼得到的LSTM隱狀態(tài))

將以上信息輸入到世界模型中更新地圖信息,即Update操作。整個(gè)Update操作經(jīng)過MLP、MaxPooling以及GRU等模塊獲得一個(gè)全局的時(shí)空地圖特征R;然后,每個(gè)LSTM(對(duì)應(yīng)一個(gè)行人),使用其當(dāng)前觀測(cè)時(shí)刻的坐標(biāo)信息:

然后與R進(jìn)行Attention操作,得到個(gè)人領(lǐng)域內(nèi)的時(shí)空特征,最后與他的坐標(biāo)信息、上時(shí)刻隱狀態(tài)信息一并輸入到LSTM并更新LSTM內(nèi)置狀態(tài)。

解碼預(yù)測(cè)階段的流程與歷史軌跡編碼階段基本一致,但存在兩個(gè)細(xì)微的不同點(diǎn):

區(qū)別1:編碼階段每個(gè)行人對(duì)應(yīng)的LSTM隱狀態(tài)的初始化為0;而解碼階段,LSTM由編碼階段的LSTM隱狀態(tài)和噪聲共同初始化。

區(qū)別2:編碼階段行人對(duì)應(yīng)的LSTM和世界模型使用的是行人歷史觀測(cè)坐標(biāo);而解碼階段使用的是上時(shí)刻預(yù)測(cè)的行人坐標(biāo)。

圖5 解碼預(yù)測(cè)階段

為了對(duì)數(shù)據(jù)有更好的理解,便于使用更適合的模型,我們對(duì)訓(xùn)練數(shù)據(jù)做了一些預(yù)處理操作。首先,數(shù)據(jù)集給出了各個(gè)行人的行為標(biāo)簽,這些標(biāo)簽是根據(jù)規(guī)則得到的,由于我們采用了交互預(yù)測(cè)的方法,希望模型能自動(dòng)學(xué)習(xí)行人與周圍主體之間的位置關(guān)系、速度關(guān)系等,所以我們就不直接使用標(biāo)注中的“類型”信息;然后這次比賽的數(shù)據(jù)采集自馬路、校園等不同場(chǎng)景中行人的運(yùn)動(dòng)軌跡,場(chǎng)景之間的差異性非常大,訓(xùn)練集和測(cè)試集數(shù)據(jù)分布不太一致。

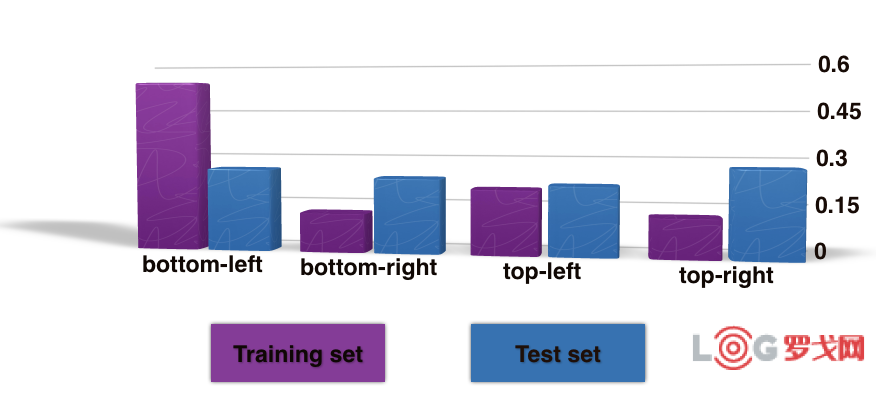

于是,我們做了數(shù)據(jù)的可視化工作,將所有軌跡數(shù)據(jù)的起點(diǎn)放置于坐標(biāo)軸的原點(diǎn)處,根據(jù)歷史觀測(cè)軌跡(前9個(gè)時(shí)刻)終點(diǎn)的位置朝向,將所有軌跡分為4類:沿左上方運(yùn)動(dòng)(top-left moving)、沿右上方運(yùn)動(dòng)(top-right moving)、沿左下方運(yùn)動(dòng)(bottom-left moving)和沿右下方運(yùn)動(dòng)(bottom-right moving)。分布的結(jié)果如圖6所示,可以發(fā)現(xiàn),訓(xùn)練集和測(cè)試集的數(shù)據(jù)分布存在一定的差距。

圖6 訓(xùn)練集與測(cè)試集歷史觀測(cè)軌跡中行人運(yùn)動(dòng)方向分布

針對(duì)上述問題,我們對(duì)訓(xùn)練集做了2項(xiàng)預(yù)處理來提高訓(xùn)練集與測(cè)試集分布的一致性:

平衡性采樣;

場(chǎng)景數(shù)據(jù)正則化(缺失軌跡點(diǎn)插值,軌跡中心化以及隨機(jī)旋轉(zhuǎn))。

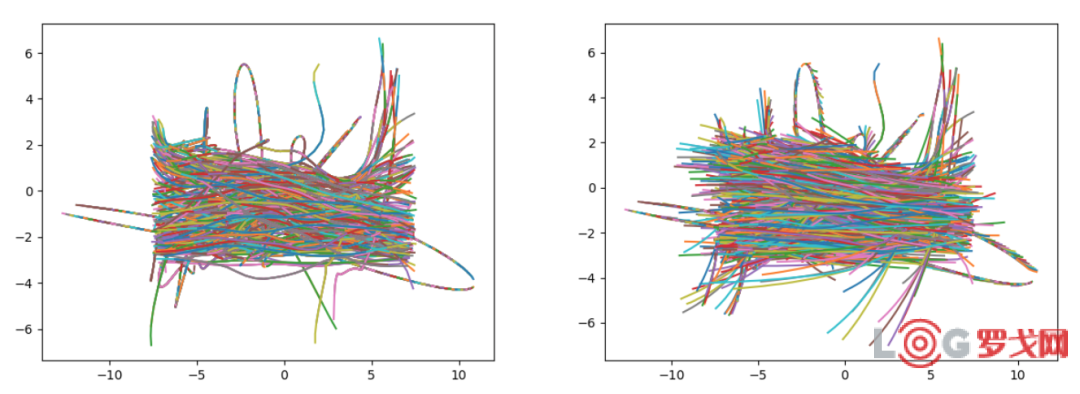

此外,對(duì)于預(yù)測(cè)結(jié)果,我們也做了相應(yīng)的后處理操作進(jìn)行軌跡修正,主要是軌跡點(diǎn)的裁剪以及基于非極大值抑制的軌跡選擇。圖7展示了兩個(gè)場(chǎng)景中行人的運(yùn)動(dòng)區(qū)域,可以看到有明顯的邊界,對(duì)于超出邊界的軌跡,我們做了相應(yīng)的修正,從而保證軌跡的合理性。

圖7 訓(xùn)練軌跡的可視化

最后在訓(xùn)練技巧上,我們也使用K-Fold Cross Validation和Grid Search方法來做自適應(yīng)的參數(shù)調(diào)優(yōu)。最終在測(cè)試集上取得FDE 1.24米的性能,而獲得比賽第二名的方法的FDE為1.30米。

行人軌跡預(yù)測(cè)是當(dāng)前一個(gè)非常熱門的研究領(lǐng)域,隨著越來越多的學(xué)者以及研究機(jī)構(gòu)的參與,預(yù)測(cè)方法也在日益地進(jìn)步與完善。美團(tuán)無人配送團(tuán)隊(duì)也期待能與業(yè)界一起在該領(lǐng)域做出更多、更好的解決方案。幸運(yùn)的是,這次競(jìng)賽的場(chǎng)景與我們美團(tuán)無人配送的場(chǎng)景具備一定的相似性,所以我們相信未來它能夠直接為業(yè)務(wù)賦能。目前,我們已經(jīng)將該研究工作在競(jìng)賽中進(jìn)行了測(cè)試,也驗(yàn)證了算法的性能,同時(shí)為該算法在業(yè)務(wù)中落地提供了一個(gè)很好的支撐。

[1] Zhang P, Ouyang W, Zhang P, et al. Sr-lstm: State refinement for lstm towards pedestrian trajectory prediction[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 12085-12094.

[2] Gupta A, Johnson J, Fei-Fei L, et al. Social gan: Socially acceptable trajectories with generative adversarial networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 2255-2264.

[3] Sadeghian A, Kosaraju V, Sadeghian A, et al. Sophie: An attentive gan for predicting paths compliant to social and physical constraints[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 1349-1358.

[4] Liang J, Jiang L, Niebles J C, et al. Peeking into the future: Predicting future person activities and locations in videos[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 5725-5734.

[5] Zhu Y, Qian D, Ren D, et al. StarNet: Pedestrian trajectory prediction using deep neural network in star topology[C]//Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems. 2019: 8075-8080.

[6] Li X, Ying X, Chuah M C. GRIP: Graph-based interaction-aware trajectory prediction[C]//Proceedings of the IEEE Intelligent Transportation Systems Conference. IEEE, 2019: 3960-3966.

[7] Mohamed A, Qian K, Elhoseiny M, et al. Social-STGCNN: A Social spatio-temporal graph convolutional neural network for human trajectory prediction[J]. arXiv preprint arXiv:2002.11927, 2020.

[8] Huang Y, Bi H K, Li Z, et al. STGAT: Modeling spatial-temporal interactions for human trajectory prediction[C]//Proceedings of the IEEE International Conference on Computer Vision. 2019: 6272-6281.

[9] Gao J, Sun C, Zhao H, et al. VectorNet: Encoding HD maps and agent dynamics from vectorized representation[J]. arXiv preprint arXiv:2005.04259, 2020.

[10] Zhu Y, Ren D, Fan M, et al. Robust trajectory forecasting for multiple intelligent agents in dynamic scene[J]. arXiv preprint arXiv:2005.13133, 2020.

炎亮,美團(tuán)無人車配送中心算法工程師。佳禾,浙江大學(xué)在讀研究生,美團(tuán)無人車配送中心實(shí)習(xí)生。德恒,美團(tuán)無人車配送中心算法工程師。冬淳,美團(tuán)無人車配送中心算法工程師。

美國(guó)對(duì)中國(guó)商品加征10%關(guān)稅,對(duì)跨境電商的巨大沖擊

990 閱讀

白犀牛副總裁王瀚基:無人配送帶來了哪些機(jī)遇與挑戰(zhàn)?

736 閱讀

SCOR模型:數(shù)字化時(shí)代供應(yīng)鏈管理的航海圖

787 閱讀快遞人2025愿望清單:漲派費(fèi)、少罰款、交社保......

725 閱讀京東物流北京區(qū)25年331大件DC承運(yùn)商招標(biāo)

642 閱讀春節(jié)假期全國(guó)攬投快遞包裹超19億件

516 閱讀1月27日-2月2日全國(guó)物流保通保暢運(yùn)行情況

517 閱讀暖心護(hù)航春節(jié)返程,順豐確保每一份滿滿當(dāng)當(dāng)?shù)男囊馀c牽掛新鮮抵達(dá)!

462 閱讀2025年1月20日-1月26日全國(guó)物流保通保暢運(yùn)行情況

429 閱讀“朝令夕改”!美國(guó)郵政恢復(fù)接收中國(guó)包裹

443 閱讀